Portail:Probabilités et statistiques/Lumière sur...

IntroductionLa section Lumière sur du portail permet de mettre en avant aléatoirement un article parmi les différentes sélections proposées ci-après. Pour ajouter un article au tirage aléatoire, veuillez suivre les étapes qui suivent :

|

Sélection 1Ronald Aylmer Fisher, était un biologiste et statisticien britannique, né à East Finchley le et mort le . Il est considéré par Richard Dawkins comme « le plus grand des successeurs de Darwin » et par Anders Hald comme l'homme qui a – « presque d'une seule main – fondé les statistiques modernes ». Bradley Efron le considère comme le statisticien le plus important du XXe siècle. Dans le domaine des statistiques, il a introduit de nombreux concepts clés tels que le maximum de vraisemblance, l'information de Fisher et l'analyse de la variance ou encore la notion de statistique exhaustive. En génétique, sa théorie dite de l'emballement fisherien permet d'expliquer la présence de traits n'augmentant pas de manière évidente les chances de survie ou succès de l'organisme. Il est considéré comme un grand précurseur de Claude Shannon. Il est également un des fondateurs de la génétique moderne et un grand continuateur de Darwin, en particulier grâce à son utilisation des méthodes statistiques, incontournables dans la génétique des populations. Il a ainsi contribué à la formalisation mathématique du principe de sélection naturelle. |

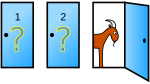

Sélection 2Le problème de Monty Hall est un casse-tête probabiliste librement inspiré du jeu télévisé américain Let's Make a Deal. Il est simple dans son énoncé mais non intuitif dans sa résolution et c'est pourquoi on parle parfois à son sujet de paradoxe de Monty Hall. Le nom de ce problème mathématique vient du nom de celui qui a présenté ce jeu aux États-Unis pendant treize ans, l'animateur d'origine canadienne Monty Hall.L'énoncé célèbre du problème fut publié dans Parade Magazine en septembre 1990 : « Supposez que vous êtes sur le plateau d'un jeu télévisé, face à trois portes et que vous devez choisir d'en ouvrir une seule, en sachant que derrière l'une d'elles se trouve une voiture et derrière les deux autres des chèvres. Vous choisissez une porte, disons la numéro 1, et le présentateur, qui lui sait ce qu'il y a derrière chaque porte, ouvre une autre porte, disons la numéro 3, porte qui une fois ouverte découvre une chèvre. Il vous demande alors : « désirez-vous ouvrir la porte numéro 2 ? ». À votre avis, est-ce à votre avantage de changer de choix et d'ouvrir la porte 2 plutôt que la porte 1 initialement choisie ? » Puisqu'il n'y a aucun moyen de savoir laquelle des deux portes restantes cache la voiture, nous pourrions supposer que conserver le choix initial ou changer notre choix n'a pas d'importance. En réalité, nous devrions changer notre choix, ainsi nous aurions deux fois plus de chance d'ouvrir la bonne porte, passant ainsi d'une probabilité de gagner de 1/3 à celle de 2/3. Lorsque le problème et sa solution furent publiés, quelque 10 000 lecteurs ont écrit au magazine pour affirmer que le raisonnement était faux. |

Sélection 3Le paradoxe du singe savant est un théorème selon lequel un singe qui tape indéfiniment et au hasard sur le clavier d’une machine à écrire pourra « presque sûrement » écrire un texte donné.Dans ce contexte, « presque sûrement » est une expression mathématique avec un sens précis et le singe n'est pas vraiment un singe mais une métaphore pour un mécanisme abstrait qui produit une séquence aléatoire de lettres à l'infini. Le théorème illustre les dangers de raisonner sur l'infini en imaginant un très grand nombre, mais fini, et vice versa. La probabilité qu'un singe tape avec exactitude un ouvrage complet comme Hamlet de Shakespeare est si minuscule que la chance de se produire au cours d'une période de temps de l'ordre de l'âge de l'univers est minuscule, mais pas nulle. Des variantes de ce théorème incluent plusieurs, voire un nombre infini, de dactylographes et le texte à écrire passe d'une simple phrase à tous les livres d'une bibliothèque. En France on parle de tous les livres de la Bibliothèque nationale de France, en anglais de l'œuvre complète de William Shakespeare. On trouve des traces de ce genre de déclaration dans les œuvres d'Aristote, Blaise Pascal et Jonathan Swift jusqu'à son évolution vers la version avec un dactylographe, Le résultat fut présenté par Émile Borel en 1909 dans son livre de probabilités. Ces « singes » ne sont pas des singes réels, et ne se comportent pas comme de vrais singes ; ils sont plutôt une métaphore vivante pour une machine abstraite à produire des lettres dans un ordre aléatoire, par exemple un ordinateur ou un générateur aléatoire connecté à une imprimante. |

Sélection 4Le terme pile ou face désigne d'une part les deux côtés d'une pièce de monnaie ou désigne plus généralement les deux côtés d'un objet ou d'une idée ; en language numismatique, pile se nomme le revers et face l'avers. D'autre part le pile ou face est un jeu de hasard se jouant avec une pièce de monnaie. Dans certaines langues, ces deux notions ont des noms différents.Le principe du jeu est de lancer une pièce équilibrée en l'air et de parier sur le côté sorti. La pièce tournoyante tombe au sol et s'y stabilise, ou bien elle est rattrapée d'une main et posée à plat dans l'autre main. La première utilisation de ce jeu sous cette forme date de la création de la monnaie métallique. Cependant, d'autres formes existaient précédemment en utilisant des objets à deux faces distinctes, un coquillage par exemple. Le but est de faire un choix binaire au hasard. Aujourd'hui encore, jouer à « pile ou face » signifie qu'on laisse une décision se prendre au hasard, en fonction du côté de la pièce qui apparaîtra après le lancer. Le jeu de pile ou face est toujours utilisé en sport par exemple. Il sert de support à beaucoup de problèmes en probabilité, certains restent encore ouverts comme le problème de la Belle au bois dormant. Il est un outil important dans la théorie des jeux ainsi que dans la théorie des probabilités. |

Sélection 5L'utilisation industrielle ou opérationnelle de ce savoir dans le monde professionnel permet de résoudre des problématiques très diverses, allant de la gestion de la relation client à la maintenance préventive, en passant par la détection de fraudes ou encore l'optimisation de sites web. L'exploration de données fait suite, dans l'escalade de l'exploitation des données de l'entreprise, à l'informatique décisionnelle. Celle-ci permet de constater un fait, tel que le chiffre d'affaires, et de l'expliquer (comme par exemple le chiffre d'affaires décliné par produits) tandis que l'exploration de données permet de classer les faits et de les prévoir dans une certaine mesure (en suivant le même exemple, il permet de répondre à la question : « Quel pourrait être le chiffre d'affaires dans un mois ? »). |

Sélection 6Christian Huygens, ou Christian Huyghens, tel qu'il est connu dans les lettres françaises depuis le Grand Siècle (, La Haye — dans la même ville) est un mathématicien, un astronome et un physicien néerlandais.Après avoir entendu parler de la correspondance de Blaise Pascal et Pierre Fermat au sujet du "problème des partis" lors d'un voyage à Paris en 1655, Huygens, encouragé par Frans van Schooten, publia le premier livre sur le calcul des probabilités dans les jeux de hasard en 1657 : De ratiociniis in ludo aleae (Sur le calcul dans les jeux de hasard). Il y définit la notion fondamentale d'espérance et y développe plusieurs problèmes de partages de gains lors de jeux ou de tirages dans des urnes. Ce livre, qu'il traduit en néerlandais en 1660, va jouer un rôle déterminant dans la diffusion de cette nouvelle mathématique; il est repris en anglais (anonymement) par John Arbuthnot en 1692, en latin par Juan Caramuel y Lobkowitz en 1670, et de manière décisive par Jacob Bernoulli dans la première partie de son Ars conjectandi" publié en 1715. |

Sélection 7Auteur de plus de 170 articles et ouvrages scientifiques, Steinhaus a laissé sa marque dans de nombreuses branches des mathématiques, comme l'analyse fonctionnelle, la géométrie, la logique mathématique ou la trigonométrie. Il est notamment considéré comme l'un des pionniers de la théorie des jeux et de la théorie des probabilités. |

Sélection 8L’analyse des données permet de traiter un nombre très important de données et de dégager les aspects les plus intéressants de la structure de celles-ci. Le succès de cette discipline dans les dernières années est dû, dans une large mesure, aux représentations graphiques fournies par les méthodes d’analyse des données. Ces schémas graphiques peuvent mettre en évidence des relations difficilement saisies par l’analyse directe des données ; mais surtout, ces représentations ne sont pas liées à une opinion « a priori » sur les lois des phénomènes analysés contrairement aux méthodes de la statistique classique. Les fondements mathématiques de l’analyse des données ont commencé à se développer au début du XXe siècle, mais ce sont les ordinateurs qui ont rendu cette discipline opérationnelle, et qui en ont permis une utilisation très étendue. Mathématiques et Informatiques sont ici intimement liées. |

Sélection 9Progressivement formalisées pendant le premier tiers du XXe siècle, les tribus constituent le cadre dans lequel s'est développée la théorie de la mesure. Les exemples les plus fameux en sont les tribus boréliennes, du nom d'Émile Borel, qui construit la tribu borélienne de la droite réelle en 1898, et la tribu de Lebesgue, formée des ensembles mesurables définis par Henri Lebesgue en 1901. En conséquence, les tribus sont aussi fondamentales en théorie des probabilités, dont l'axiomatisation moderne s'appuie sur la théorie de la mesure. Dans ce domaine, les tribus ne sont pas seulement le support du formalisme, mais aussi un outil puissant, qui est à la base de la définition de concepts parmi les plus importants : espérance conditionnelle, martingales, etc. |

Sélection 10Plus formellement, c'est une loi de probabilité absolument continue qui dépend de deux paramètres : son espérance, un nombre réel noté , et son écart type, un nombre réel positif noté . La densité de probabilité de la loi normale est donnée par : La courbe de cette densité est appelée courbe de Gauss ou courbe en cloche, entre autres. C'est la représentation la plus connue de cette loi. La loi normale de moyenne nulle et d'écart type unitaire est appelée loi normale centrée réduite ou loi normale standard. Lorsqu'une variable aléatoire suit la loi normale, elle est dite gaussienne ou normale et il est habituel d'utiliser la notation avec la variance : Parmi les lois de probabilité, la loi normale prend une place particulière grâce au théorème central limite. En effet, elle correspond au comportement d'une suite d'expériences aléatoires similaires et indépendantes lorsque le nombre d'expériences est très élevé. Grâce à cette propriété, la loi normale permet d'approcher d'autres lois et ainsi de modéliser de nombreuses études scientifiques comme des mesures d'erreurs ou des tests statistiques, en utilisant par exemple les tables de la loi normale. |

Sélection 11C'est une grandeur dont l'invention remonte à la période du XXe siècle qui vit la statistique se développer au Royaume-Uni. Les écarts types sont rencontrés dans tous les domaines où sont appliqués les probabilités et la statistique, en particulier dans le domaine des sondages, en physique, en biologie ou dans la finance. Ils permettent en général de synthétiser les résultats numériques d'une expérience répétée. Tant en probabilités qu'en statistique, il sert à l'expression d'autres notions importantes comme le coefficient de corrélation, ou la répartition optimale de Neyman. Quand l'écart type d'une population est inconnu, sa valeur est approchée à l'aide d'estimateurs. Sur de grands ensembles de données, l'écart type peut être calculé grâce à l'ordinateur mais il faut rechercher le bon algorithme. |

Sélection 12Des fluctuations ou de la variabilité sont présentes dans presque toute valeur qui peut être mesurée lors de l'observation d'un phénomène, quelle que soit sa nature ; de plus presque toutes les mesures ont une part d'erreur intrinsèque. Les lois de probabilités permettent de modéliser ces incertitudes et de décrire des phénomènes physiques, biologiques, économiques, etc. Le domaine de la statistique permet de trouver des lois de probabilités adaptées aux phénomènes aléatoires. Il existe beaucoup de lois de probabilités différentes. Parmi toutes ces lois, la loi normale a une importance particulière puisque, d'après le théorème central limite, elle approche le comportement asymptotique de nombreuses lois de probabilités. Le concept de loi de probabilité se formalise mathématiquement à l'aide de la théorie de la mesure : une loi de probabilité est une mesure, souvent vue comme la loi décrivant le comportement d'une variable aléatoire, discrète ou continue. Une mesure est une loi de probabilité si sa masse totale vaut 1. L'étude d'une variable aléatoire suivant une loi de probabilité discrète fait apparaître des calculs de sommes et de séries, alors que si sa loi est absolument continue, l'étude de la variable aléatoire fait apparaître des calculs d'intégrales. Des fonctions particulières permettent de caractériser les lois de probabilité, par exemple la fonction de répartition et la fonction caractéristique. |

Sélection 13La théorie des probabilités est l'étude mathématique des phénomènes caractérisés par le hasard et l'incertitude. Elle forme avec la statistique les deux sciences du hasard qui sont partie intégrante des mathématiques. Les débuts de l'étude des probabilités correspondent aux premières observations du hasard dans les jeux ou dans les phénomènes climatiques par exemple.Bien que le calcul de probabilités sur des questions liées au hasard existe depuis longtemps, la formalisation mathématique n'est que récente. Elle date du début du XXe siècle avec l'axiomatique de Kolmogorov. Des objets tels que les événements, les mesures de probabilité, les espaces probabilisés ou les variables aléatoires sont centraux dans la théorie. Ils permettent de traduire de manière abstraite les comportements ou des quantités mesurées qui peuvent être supposés aléatoires. En fonction du nombre de valeurs possibles pour le phénomène aléatoire étudié, la théorie des probabilités est dite discrète ou continue. Dans le cas discret, c'est-à-dire pour un nombre au plus dénombrable d'états possibles, la théorie des probabilités se rapproche de la théorie du dénombrement ; alors que dans le cas continu, la théorie de l'intégration et la théorie de la mesure donnent les outils nécessaires. Les objets et résultats probabilistes sont un support nécessaire à la statistique, c'est le cas par exemple du théorème de Bayes, de l'évaluation des quantiles ou du théorème central limite et de la loi normale. Cette modélisation du hasard permet également de résoudre plusieurs paradoxes probabilistes. Qu'il soit discret ou continu, le calcul stochastique est l'étude des phénomènes aléatoires qui dépendent du temps. La notion d'intégrale stochastique et d'équation différentielle stochastique font partie de cette branche de la théorie des probabilités. Ces processus aléatoires permettent de faire des liens avec plusieurs domaines plus appliqués tels que les mathématiques financières, la mécanique statistique, le traitement d'images, etc. |

Sélection 14Blaise Pascal, né le à Clairmont (aujourd'hui Clermont-Ferrand) en Auvergne, mort le à Paris, est un mathématicien, physicien, inventeur, philosophe, moraliste et théologien français.Enfant précoce, son père l'éduque. Les premiers travaux de Pascal concernent les sciences naturelles et appliquées. Il contribue de manière importante à l’étude des fluides. Il a clarifié les concepts de pression et de vide, en étendant le travail de Torricelli. Pascal a écrit des textes importants sur la méthode scientifique. À 18 ans, en 1641, il invente la première machine à calculer et après trois ans de développement et 50 prototypes, il la présente à ses contemporains en la dédiant au chancelier Séguier. Dénommée machine d’arithmétique, puis roue pascaline et enfin pascaline, il en construisit une vingtaine d'exemplaires dans la décennie suivante. Mathématicien de premier ordre, il crée deux nouveaux champs de recherche majeurs : tout d’abord il publie un traité de géométrie projective à seize ans ; ensuite il développe en 1654 une méthode de résolution du « problème des partis » qui, donnant naissance au cours du XVIIIe siècle au calcul des probabilités, influencera fortement les théories économiques modernes et les sciences sociales. Après une expérience mystique qu'il éprouva à la suite d'un accident de carrosse en octobre 1654, il se consacre à la réflexion philosophique et religieuse. Il écrit pendant cette période Les Provinciales et les Pensées, ces dernières n’étant publiées qu’après sa mort qui survient deux mois après son 39e anniversaire, alors qu’il a été longtemps malade (sujet à des migraines violentes en particulier). |

Sélection 15En théorie des probabilités et en statistique, la loi binomiale modélise le nombre de succès obtenus lors de la répétition indépendante de plusieurs expériences aléatoires identiques. Une manière visuelle de représenter cette suite d'expériences est d'utiliser un arbre de probabilité : à chaque génération de l'arbre, deux branches partent de chaque nœud, une pour le succès et une pour l'échec.Plus mathématiquement, cette loi de probabilité discrète est décrite par deux paramètres : le nombre d'expériences réalisées et la probabilité de succès. Pour chaque expérience appelée épreuve de Bernoulli, on utilise une variable aléatoire qui prend la valeur 1 lors d'un succès et la valeur 0 sinon. La variable aléatoire, somme de toutes ces variables aléatoires, compte le nombre de succès et est de loi binomiale. Il est alors possible d'obtenir la probabilité de succès dans une répétition de expériences :

Cette formule fait intervenir le coefficient binomial duquel provient le nom de la loi. L'importance de cette loi est d'abord historique puisqu'elle a été l'objet d'étude du théorème de Moivre-Laplace, résultat du xviiie siècle fondateur des théorèmes de convergence. La loi a également son utilité pour modéliser des situations simples de succès ou échec, un jeu de pile ou face par exemple. Le calcul de sa fonction de masse devient rapidement fastidieux lorsque est grand, il est alors possible d'utiliser des approximations par d'autres lois de probabilité telles que la loi de Poisson ou la loi normale et d'utiliser des tables de valeurs. La loi binomiale est utilisée dans divers domaines d'étude, notamment à travers des tests statistiques qui permettent d'interpréter des données et de prendre des décisions dans des situations dépendant de l'aléa. De par la simplicité de sa définition, c'est l'une des lois de probabilité étudiées dans les cours d'introduction à la théorie des probabilités. |

Sélection 16En théorie des probabilités et en statistique, des variables indépendantes et identiquement distribuées sont des variables aléatoires qui suivent toutes la même loi de probabilité et sont indépendantes. On dit que ce sont des variables aléatoires iid ou plus simplement des variables iid.Un exemple classique de variables aléatoires iid apparait lors d'un jeu de pile ou face, c'est-à-dire des lancers successifs d'une même pièce. Les variables aléatoires qui représentent chaque résultat des lancers (0 pour face et 1 pour pile) suivent toutes la même loi de Bernoulli. De plus les lancers étant successifs, les résultats n'ont pas de lien de dépendance entre eux et ainsi les variables aléatoires sont indépendantes. L'apparition de variables iid se retrouve régulièrement en statistique. En effet, lorsque l'on étudie un caractère sur une population, on réalise un échantillon : on sélectionne une partie de la population, on mesure le caractère étudié et on obtient ainsi une série de valeurs qui sont supposées aléatoires, indépendantes les unes des autres et qui sont modélisées par des variables aléatoires avec une loi de probabilité adaptée. Inversement, lorsque l'on récupère des données statistiques, des méthodes permettent de savoir si elles sont issues de variables iid. Plusieurs théorèmes de probabilité nécessitent l'hypothèse de variables indépendantes et identiquement distribuées. En particulier le théorème central limite dans sa forme classique énonce que la somme renormalisée de variables iid tend vers une loi normale. C'est également le cas de la loi des grands nombres qui assure que la moyenne de variables iid converge vers l'espérance de la loi de probabilité des variables. Des méthodes de calcul comme la méthode de Monte-Carlo utilisent des variables iid. Il est alors utile de savoir simuler informatiquement des valeurs iid ; ces valeurs simulées sont dites pseudo-aléatoires car obtenir des valeurs parfaitement iid est impossible. Les algorithmes utilisant la congruence sur les entiers ne donnent pas d'indépendance parfaite, on peut parler de hasard faible. En utilisant des phénomènes physiques, il est possible d'obtenir de meilleures valeurs pseudo-aléatoires, il s'agit de hasard fort. On utilise alors l'ancienne méthode des tables de nombres aléatoires. |

Sélection 17 |

Sélection 18 |

Sélection 19 |

Sélection 20 |

Sélection 21 |

Sélection 22 |

Sélection 23 |

Sélection 24 |

Sélection 25 |

Sélection 26 |

Sélection 27 |

Sélection 28 |

Sélection 29 |

Sélection 30 |

Sélection 31 |

Sélection 32 |

Sélection 33 |

Sélection 34 |

Sélection 35 |

Sélection 36 |

Sélection 37 |

Sélection 38 |

Sélection 39 |

Sélection 40 |

Sélection 41 |

Sélection 42 |

Sélection 43 |

Sélection 44 |

Sélection 45 |

Sélection 46 |

Sélection 47 |

Sélection 48 |

Sélection 49 |

Sélection 50 |